一文读懂|DeepSeek新模型大揭秘,为何它能震动全球AI圈

时隔不到一个月,DeepSeek又一次震动全球AI圈。

去年 12 月,DeepSeek推出的DeepSeek-V3在全球AI领域掀起了巨大的波澜,它以极低的训练成本,实现了与GPT-4o和Claude Sonnet 3.5等顶尖模型相媲美的性能,震惊了业界。

腾讯科技曾对此模型进行深度解读,用最简单直白的语言阐释其实现低成本和高效能的技术背景(点击可查看)。

和上次不同的是,这次推出的新模型DeepSeek-R1不仅成本低,更是在技术上有了大福提升。

而且,它还是一个开源模型。

这款新模型延续了其高性价比的优势,仅用十分之一的成本就达到了GPT-o1级别的表现。

所以,很多业内人士甚至喊出了“DeepSeek接班OpenAI”的口号。

比如,前Meta AI工作人员、知名AI论文推特作者Elvis就强调,DeepSeek-R1的论文堪称瑰宝,因为它探索了提升大语言模型推理能力的多种方法,并发现了其中更明确的涌现特性。

另一位AI圈大V Yuchen Jin则认为,DeepSeek-R1论文中提出的,模型利用纯RL方法引导其自主学习和反思推理这一发现,意义非常重大。

英伟达GEAR Lab项目负责人Jim Fan在推特中也提到了,DeepSeek-R1用通过硬编码规则计算出的真实奖励,而避免使用任何 RL 容易破解的学习奖励模型。这使得模型产生了自我反思与探索行为的涌现。Jim Fan 甚至认为,它们做了OpenAI本来应该做的事,开源。

那么问题来了,他们所提到的纯RL方法训练模型是指什么?模型出现的“Aha Moment”,又凭什么能证明AI具有了涌现能力?我们更想知道的是,DeepSeek-R1的这一重要创新对于AI领域未来的发展,究竟意味着什么?

用最简单的配方,

回归最纯粹的强化学习

在o1推出之后,推理强化成了业界最关注的方法。

一般来说,一个模型在训练过程中只会尝试一种固定训练方法来提升推理能力。

而DeepSeek团队在R1的训练过程中,直接一次性实验了三种截然不同的技术路径:直接强化学习训练(R1-Zero)、多阶段渐进训练(R1)和模型蒸馏,还都成功了。多阶段渐进训练方法和模型蒸馏都包含着很多创新意义元素,对行业有着重要影响。

其中最让人激动的,还是直接强化学习这个路径。因为DeepSeek-R1是首个证明这一方法有效的模型。

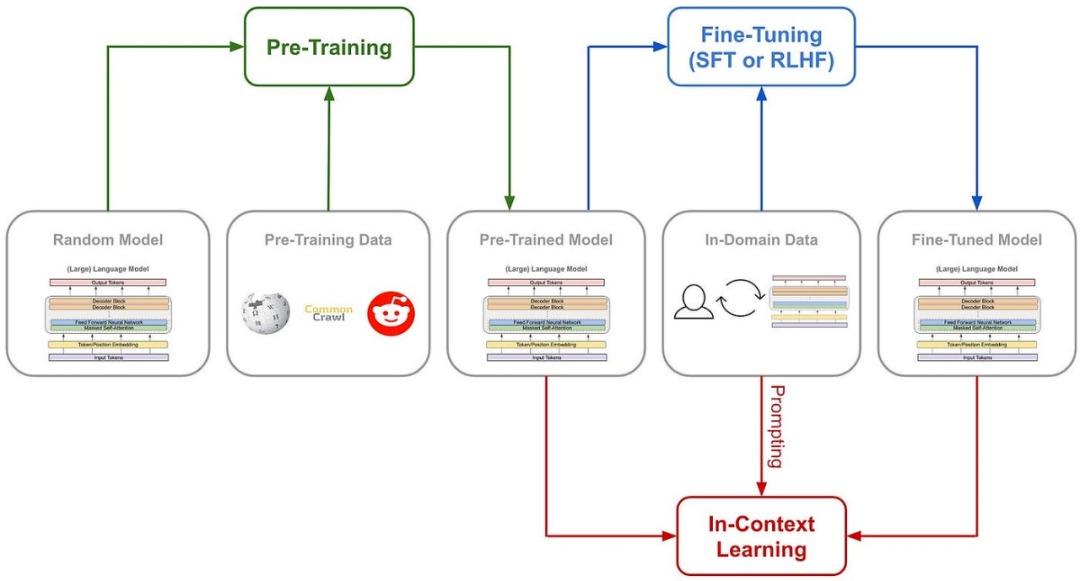

我们先来了解一下,训练AI的推理能力传统的方法通常是什么:一般是通过在SFT(监督微调)加入大量的思维链(COT)范例,用例证和复杂的如过程奖励模型(PRM)之类的复杂神经网络奖励模型,来让模型学会用思维链思考。

甚至会加入蒙特卡洛树搜索(MCTS),让模型在多种可能中搜索最好的可能。

传统的模型训练路径但DeepSeek-R1-Zero选择了一条前所未有的路径“纯”强化学习路径,它完全抛开了预设的思维链模板(Chain of Thought)和监督式微调(SFT),仅依靠简单的奖惩信号来优化模型行为。

这就像让一个天才儿童在没有任何范例和指导的情况下,纯粹通过不断尝试和获得反馈来学习解题。

DeepSeek-R1-Zero 有的只是一套最简单的奖励系统,来激发AI的推理能力。

这个规则就两条:

1. 准确性奖励:准确性奖励模型评估响应是否正确。对了就加分,错了扣分。评价方法也很简单:例如,在具有确定性结果的数学问题中,模型需要以指定格式(如和间)提供最终答案;对于编程问题,可以使用编译器根据预定义的测试用例生成反馈。

2. 格式奖励:格式奖励模型强制要求模型将其思考过程置于和标签之间。没这么做就扣分,做了就加分。

为了准确观察模型在强化学习(RL)过程中的自然进展,DeepSeek甚至有意将系统提示词仅约束限制在这种结构格式上,来避免任何内容特定的偏见——例如强制让模型进行反思性推理或推广特定的问题解决策略。

转自:腾讯新闻